single

Gradient-Tape

Gradient-Tape

Swipe um das Menü anzuzeigen

Gradient Tape

Das Verständnis grundlegender Tensor-Operationen ermöglicht es, diese Prozesse mithilfe von integrierten TensorFlow-Funktionen zu optimieren und zu beschleunigen. Das erste dieser fortgeschrittenen Werkzeuge, das betrachtet wird, ist das Gradient Tape.

Was ist Gradient Tape?

Dieses Kapitel behandelt eines der grundlegenden Konzepte in TensorFlow, das Gradient Tape. Diese Funktion ist entscheidend für das Verständnis und die Implementierung von gradientenbasierten Optimierungstechniken, insbesondere im Deep Learning.

Gradient Tape in TensorFlow ist ein Werkzeug, das Operationen für die automatische Differenzierung aufzeichnet. Wenn Operationen innerhalb eines Gradient Tape-Blocks ausgeführt werden, verfolgt TensorFlow alle Berechnungen, die stattfinden. Dies ist besonders nützlich beim Training von Machine-Learning-Modellen, bei denen Gradienten zur Optimierung der Modellparameter benötigt werden.

Im Wesentlichen ist ein Gradient eine Menge partieller Ableitungen.

Verwendung von Gradient Tape

Für die Nutzung von Gradient Tape sind folgende Schritte erforderlich:

- Erstellen eines Gradient Tape-Blocks: Verwenden von

with tf.GradientTape() as tape:. Innerhalb dieses Blocks werden alle Berechnungen aufgezeichnet; - Definition der Berechnungen: Ausführen von Operationen mit Tensoren innerhalb des Blocks (z. B. Definition eines Forward-Passes eines neuronalen Netzes);

- Berechnung der Gradienten: Verwenden von

tape.gradient(target, sources), um die Gradienten des Ziels in Bezug auf die Quellen zu berechnen.

Einfache Gradientenberechnung

Ein einfaches Beispiel zur besseren Veranschaulichung.

123456789101112131415import tensorflow as tf # Define input variables x = tf.Variable(3.0) # Start recording the operations with tf.GradientTape() as tape: # Define the calculations y = x * x # Extract the gradient for the specific input (`x`) grad = tape.gradient(y, x) print(f'Result of y: {y}') print(f'The gradient of y with respect to x is: {grad.numpy()}')

Dieser Code berechnet das Gradienten von y = x^2 bei x = 3. Dies entspricht der partiellen Ableitung von y bezüglich x.

Mehrere partielle Ableitungen

Wenn die Ausgabe von mehreren Eingaben beeinflusst wird, kann eine partielle Ableitung bezüglich jeder dieser Eingaben (oder nur ausgewählter) berechnet werden. Dies geschieht durch die Übergabe einer Liste von Variablen als sources-Parameter.

Das Ergebnis dieser Operation ist eine entsprechende Liste von Tensoren, wobei jeder Tensor die partielle Ableitung bezüglich einer der in sources angegebenen Variablen darstellt.

1234567891011121314151617import tensorflow as tf # Define input variables x = tf.Variable(tf.fill((2, 3), 3.0)) z = tf.Variable(5.0) # Start recording the operations with tf.GradientTape() as tape: # Define the calculations y = tf.reduce_sum(x * x + 2 * z) # Extract the gradient for the specific inputs (`x` and `z`) grad = tape.gradient(y, [x, z]) print(f'Result of y: {y}') print(f"The gradient of y with respect to x is:\n{grad[0].numpy()}") print(f"The gradient of y with respect to z is: {grad[1].numpy()}")

Dieser Code berechnet das Gradientenfeld der Funktion y = sum(x^2 + 2*z) für gegebene Werte von x und z. In diesem Beispiel wird der Gradient von x als ein 2D-Tensor dargestellt, wobei jedes Element der partiellen Ableitung des jeweiligen Wertes in der ursprünglichen x-Matrix entspricht.

Für weiterführende Informationen zu den Fähigkeiten von Gradient Tape, einschließlich höherer Ableitungen und der Extraktion der Jacobi-Matrix, siehe die offizielle TensorFlow-Dokumentation.

Swipe to start coding

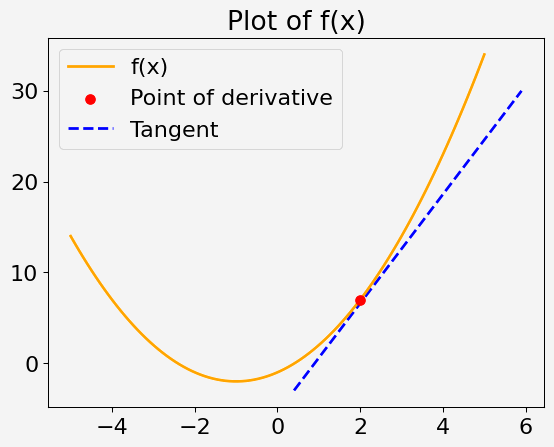

Ihr Ziel ist es, die Ableitung (Gradient) einer gegebenen mathematischen Funktion an einem bestimmten Punkt mithilfe von TensorFlows Gradient Tape zu berechnen. Die Funktion und der Punkt werden vorgegeben, und Sie sehen, wie Sie TensorFlow verwenden, um den Gradienten an diesem Punkt zu bestimmen.

Betrachten Sie eine quadratische Funktion einer einzelnen Variablen x, definiert als:

f(x) = x^2 + 2x - 1

Ihre Aufgabe ist es, die Ableitung dieser Funktion bei x = 2 zu berechnen.

Schritte

- Definieren Sie die Variable

xan dem Punkt, an dem Sie die Ableitung berechnen möchten. - Verwenden Sie Gradient Tape, um die Berechnung der Funktion

f(x)aufzuzeichnen. - Berechnen Sie den Gradienten von

f(x)am angegebenen Punkt.

Hinweis

Der Gradient kann nur für Werte vom Fließkommatyp berechnet werden.

Lösung

Danke für Ihr Feedback!

single

Fragen Sie AI

Fragen Sie AI

Fragen Sie alles oder probieren Sie eine der vorgeschlagenen Fragen, um unser Gespräch zu beginnen